Ngành bán dẫn từng vận hành theo một quy luật gần như bất biến: công nghệ hàng đầu của năm nay sẽ “chảy” xuống phân khúc tầm trung và giá rẻ trong những năm sau — thuật ngữ phổ biến là “waterfall effect” (thác nước). Tuy nhiên, Chris Bergey, Phó Chủ tịch cấp cao kiêm Tổng giám đốc mảng Client của Arm, cảnh báo quy luật này đang bị kéo căng đến giới hạn do chi phí và độ phức tạp của chip cao cấp liên tục tăng, đặc biệt khi on-device AI trở thành tiêu chuẩn mới (XDA-Developers). Bài viết phân tích nguyên nhân khiến mô hình lan tỏa này gặp khủng hoảng, cách các hãng thích nghi và hệ quả đối với người dùng cuối.

Thác nước chip là gì và vì sao nó quan trọng

Thác nước chip mô tả thực tế công nghiệp: chi phí R&D và sản xuất cao của SoC hàng đầu được phân bổ bằng cách tái sử dụng thiết kế đó cho mẫu tầm trung hoặc tinh chỉnh nhẹ để ra bản giá rẻ. Người tiêu dùng hưởng lợi trực tiếp — tính năng, hiệu năng và kết nối cao cấp được phổ cập dần. Khi “thác nước” hoạt động trơn tru, ekosystem thiết bị tiêu dùng có nhịp tiến hóa ổn định: từ flagship xuống mid-range, rồi xuống entry-level.

Nhưng theo Bergey, đường đi của thác nước đang bị “kéo căng” (strained) vì:

- Chi phí phát triển và sản xuất đỉnh cao tăng phi mã.

- Yêu cầu tích hợp các khối chuyên dụng cho AI (NPU), modem, xử lý hình ảnh… làm die size không giảm.

- Kết quả: không còn dư địa tài chính để “đóng gói lại” silicon cao cấp cho phân khúc thấp hơn mà không phá vỡ tỷ suất lợi nhuận.

Chi phí chip tăng vọt: những con số và cơ chế

Tăng chi phí không chỉ là cảm nhận — nó có dữ liệu hậu thuẫn. Sản xuất trên node tiên tiến (ví dụ 3nm) kéo theo chi phí wafer và quy trình đắt đỏ (EUV, vật liệu mới), trong khi lợi ích về mật độ transistor không còn đạt mức tỉ lệ trước đây. TechSpot báo cáo giá wafer cho các node 3nm đã tăng mạnh so với node 28nm cũ (TechSpot). Apple là minh chứng thực tế: transistor từ ~1 tỷ (A7) lên tới ~20 tỷ (A18 Pro), còn diện tích die vẫn tương đối lớn (ví dụ M1 khoảng 118.9 mm²) — tức là nhiều transistor hơn trên diện tích tương đương, nhưng chi phí/mm² tăng.

Thêm vào đó, on-device AI làm gia tăng nhu cầu về:

- NPU/AI accelerators: cần silicon chuyên dụng, tăng diện tích die.

- Bộ nhớ lớn và băng thông cao: các mô hình AI nhỏ chạy tại chỗ tiêu thụ RAM đáng kể, đẩy chi phí linh kiện lên.

- Điện năng và hệ thống quản lý năng lượng phức tạp hơn.

Hệ quả: chip flagship có đơn giá sản xuất cao đến mức một SoC đơn lẻ có thể ngang bằng chi phí sản xuất cả một thiết bị bình dân (dẫn lời Bergey; có tin đồn về chi phí >$200 cho một Snapdragon cao cấp) (XDA, tin đồn Qualcomm).

Kết quả benchmark CPU Geekbench 6 của Snapdragon 8 Elite Gen 5 cho thấy áp lực hiệu năng trên các SoC cao cấp

Kết quả benchmark CPU Geekbench 6 của Snapdragon 8 Elite Gen 5 cho thấy áp lực hiệu năng trên các SoC cao cấp

Các chiến lược công nghiệp: thiết kế phân khúc và tối ưu hóa diện tích

Thay vì chỉ “đóng gói lại” silicon cao cấp cũ, các công ty bắt đầu thiết kế lõi và SoC hướng mục tiêu cho những phân khúc mới — nhỏ hơn, tiết kiệm diện tích nhưng vẫn giữ được hiệu năng cần thiết. Arm C1‑Premium được Bergey nêu ra như ví dụ: nhỏ hơn ~35% so với C1‑Ultra nhưng đạt hiệu năng tương đương trên nhiều bài benchmark, giúp tạo SoC tầm trung-cao với chi phí sản xuất thấp hơn.

Ở tầng khác, việc tích hợp 5G vào thiết bị giá rẻ diễn ra không phải bằng cách cho vào nguyên modem đắt đỏ, mà bằng các bước công nghệ vừa phải làm chi phí giảm đáng kể so với ban đầu — người dùng chịu một khoản phí bảo hiểm nhỏ (~15% theo Bergey) để đổi lấy kết nối mới, và sau đó giá công nghệ tiếp tục giảm dần.

Chuyển đổi chiến lược còn bao gồm:

- Thiết kế modular, cho phép tắt/bật IP blocks để điều chỉnh chi phí.

- Tối ưu hóa cho workloads AI thực tế thay vì chase điểm benchmark tổng quát.

- Áp dụng binning thông minh kết hợp thiết kế riêng cho phân khúc.

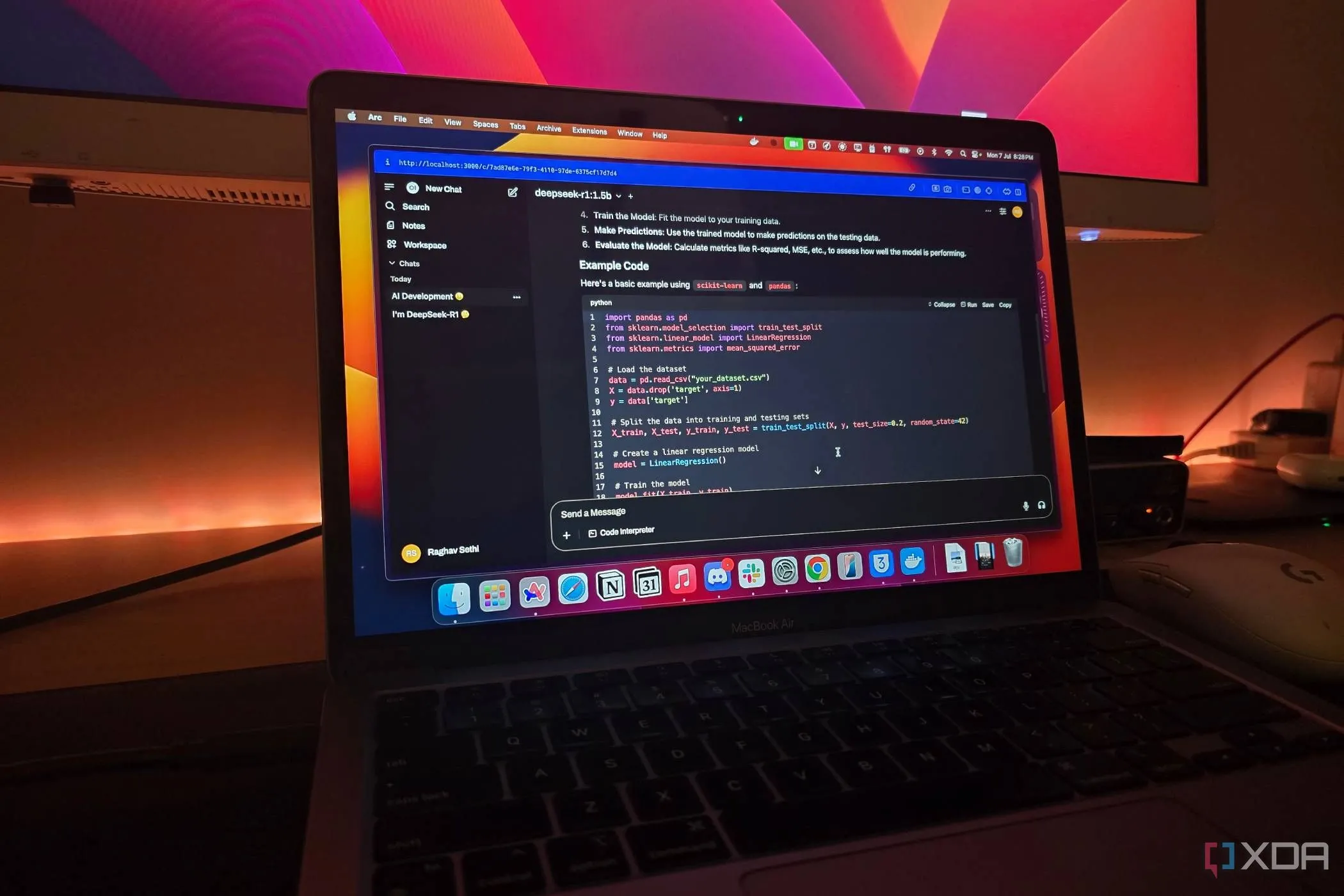

MacBook Air chạy mô hình DeepSeek-R1 cục bộ: ví dụ của việc dịch chuyển tải AI về thiết bị để giảm chi phí cloud

MacBook Air chạy mô hình DeepSeek-R1 cục bộ: ví dụ của việc dịch chuyển tải AI về thiết bị để giảm chi phí cloud

AI — con dao hai lưỡi và cơ hội mô hình doanh thu mới

AI vừa là nguyên nhân vừa là lời giải. Nó đẩy chi phí phần cứng lên (logic, memory, NPU) nhưng đồng thời mở ra cơ hội tạo ra giá trị bổ sung: trợ lý cá nhân thông minh, xử lý hình ảnh siêu việt, generative features — những tính năng có thể khiến người dùng sẵn sàng trả thêm. Ngoài ra, AI tạo cơ hội doanh thu phụ trợ: dịch vụ thuê bao, nền tảng, quảng cáo hoặc bán các mô hình/đoạn inference như một dịch vụ.

Một động lực khác: chi phí vận hành AI trên cloud không rẻ; chính các nhà cung cấp cloud lớn cũng muốn giảm tải qua thiết bị để giảm chi phí dài hạn. Vì thế, đầu tư vào on‑device inference được xem là cách cân bằng chi phí vận hành và trải nghiệm người dùng (tham khảo các phân tích chi phí API/Cloud AI).

Biểu đồ benchmark Snapdragon X2 Elite Extreme: áp lực hiệu năng và chi phí trên các thiết kế SoC hàng đầu

Biểu đồ benchmark Snapdragon X2 Elite Extreme: áp lực hiệu năng và chi phí trên các thiết kế SoC hàng đầu

Kết luận: thác nước không biến mất, nó đang được định hình lại

Quan điểm của Bergey không phải là bi quan tuyệt đối mà là cảnh báo về một ngã rẽ: khi chi phí công nghệ đỉnh tăng lên, mô hình lan tỏa truyền thống trở nên kém hiệu quả và cần đổi mới. Kết quả hợp lý nhất không phải là “thác nước cạn” mà là “thác nước được tái định hướng”: nhiều sáng kiến đồng thời — thiết kế phân khúc thông minh, tối ưu cho AI, mô hình doanh thu dịch vụ — sẽ giúp đẩy một phần giá trị xuống các tầng thấp hơn, nhưng với cách thức và tốc độ khác.

Với game thủ và người dùng cuối, hệ quả thực tế có thể là:

- Một số tính năng AI tiên tiến chỉ có ở thiết bị cao cấp trong ngắn hạn.

- Các lựa chọn tầm trung ngày càng được tối ưu để phục vụ trải nghiệm AI thực dụng.

- Giá thiết bị có thể tăng cho các chức năng mới, nhưng kèm theo mô hình dịch vụ bù đắp.

Bạn nghĩ sao về tác động của on‑device AI đến giá cả và lựa chọn phần cứng? Hãy chia sẻ quan điểm của bạn để cộng đồng gviet.net cùng thảo luận.

Tài liệu tham khảo

- Phỏng vấn Chris Bergey, XDA-Developers: //www.xda-developers.com (bài phỏng vấn gốc)

- Báo cáo chi phí wafer và node của TSMC/Apple — TechSpot: //www.techspot.com/news/106217-apple-3nm-tsmc-wafer-costs-soar-18000-more.html

- Tin đồn chi phí chipset Qualcomm Snapdragon (nguồn truyền thông xã hội / X): //x.com/yabhishekhd/status/1976628965604553189

- Phân tích chi phí vận hành AI và mô hình sinh lời: báo cáo phân tích thị trường AI (tham khảo các bài phân tích công khai về chi phí API của OpenAI và các nhà cung cấp lớn)